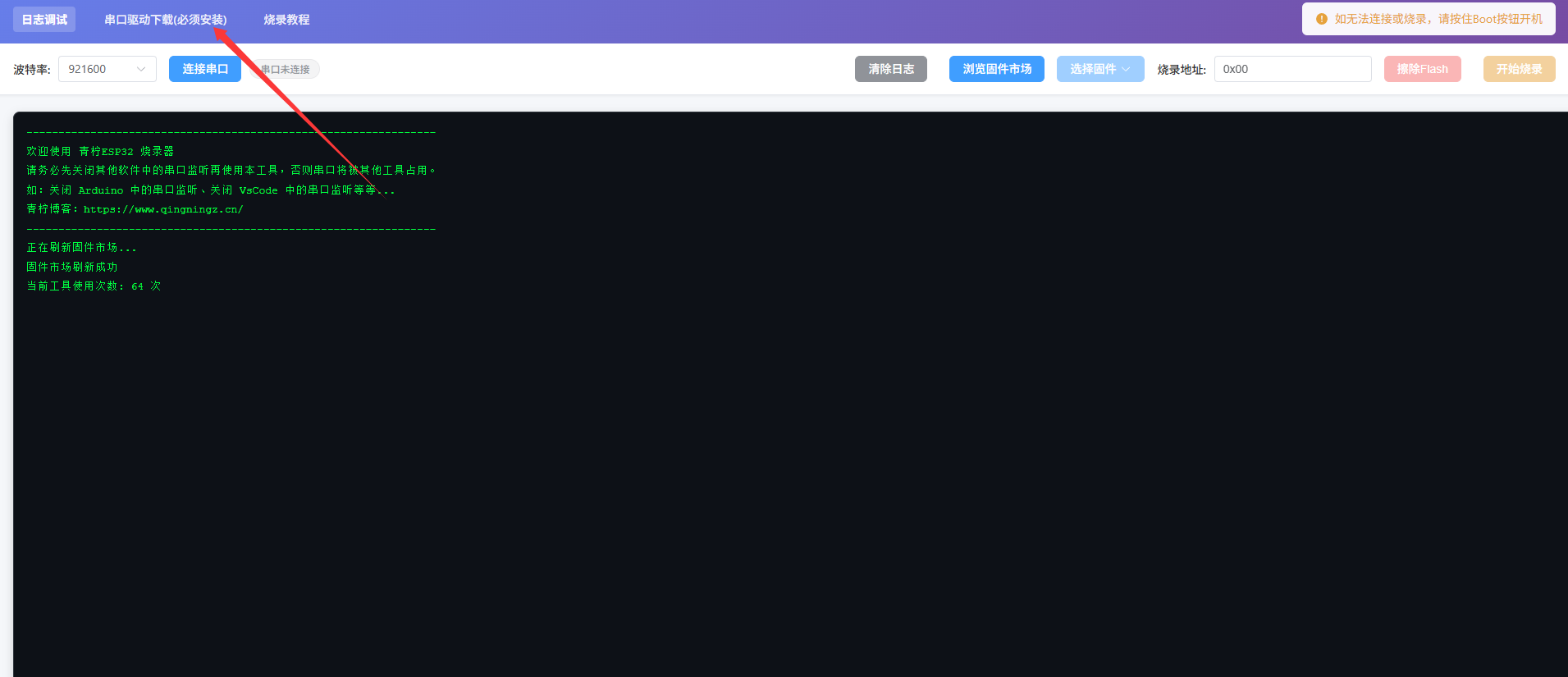

配置说明:

我这里不是用docker部署的服务端,是用npm部署,用nodejs运行的

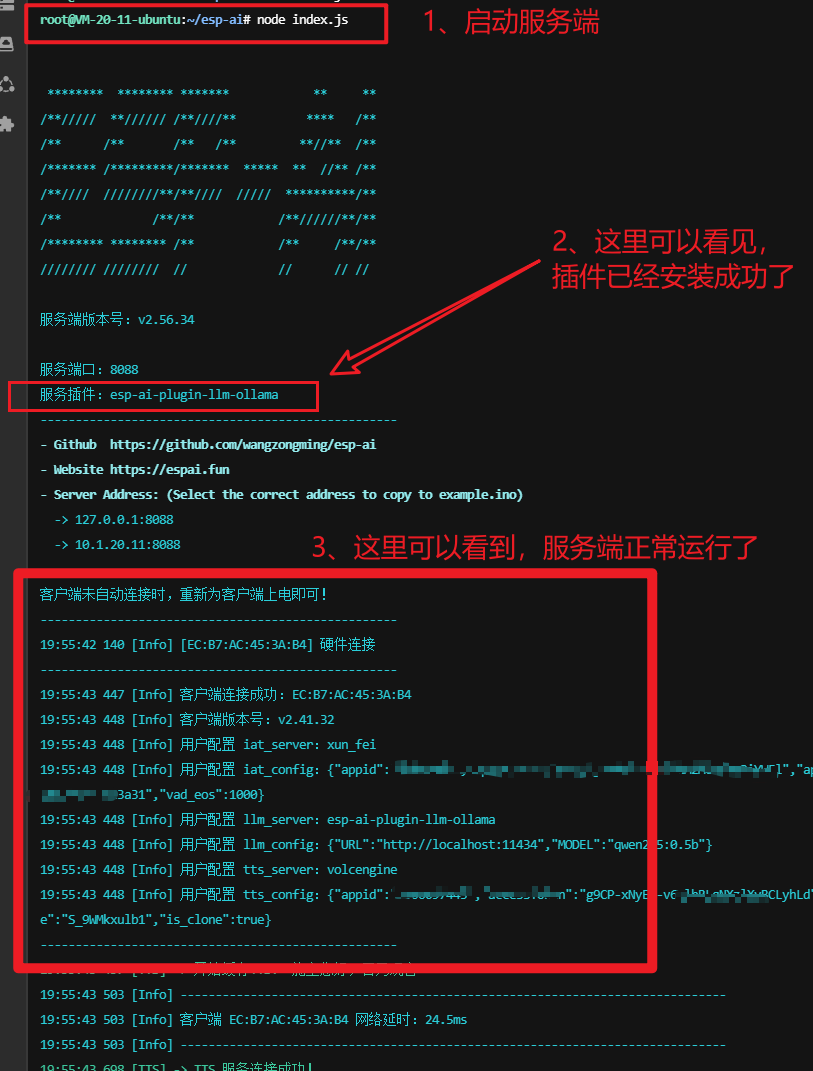

- esp-ai版本:v2.56.34

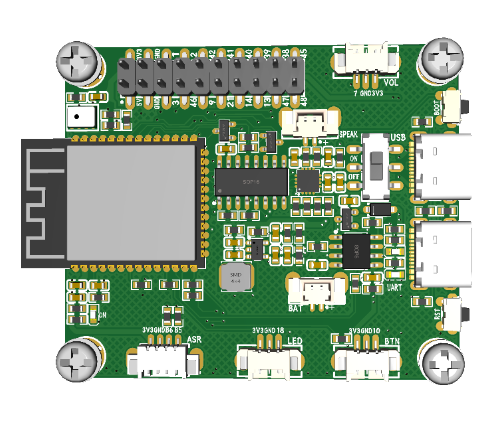

- 单片机客户端版本:2.41.32

- npm版本:9.3.1

- nodejs版本:v22.14.0

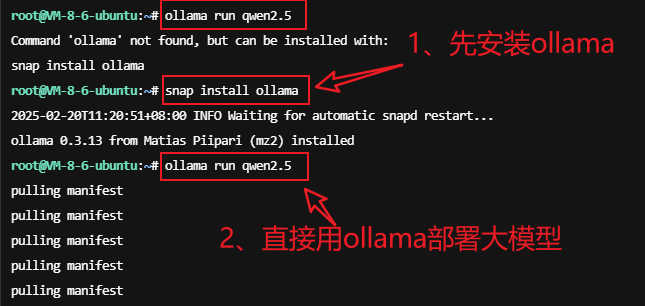

1、通过ollama部署大模型

相关资料:

-

想安装什么大模型,可以去ollama大模型库下载:https://ollama.com/search

-

Ollama软件官方下载链接:https://ollama.com/download/linux

首先用ollama去部署大模型:

snap install ollama #安装ollama,ollama相当于一个大模型管理工具

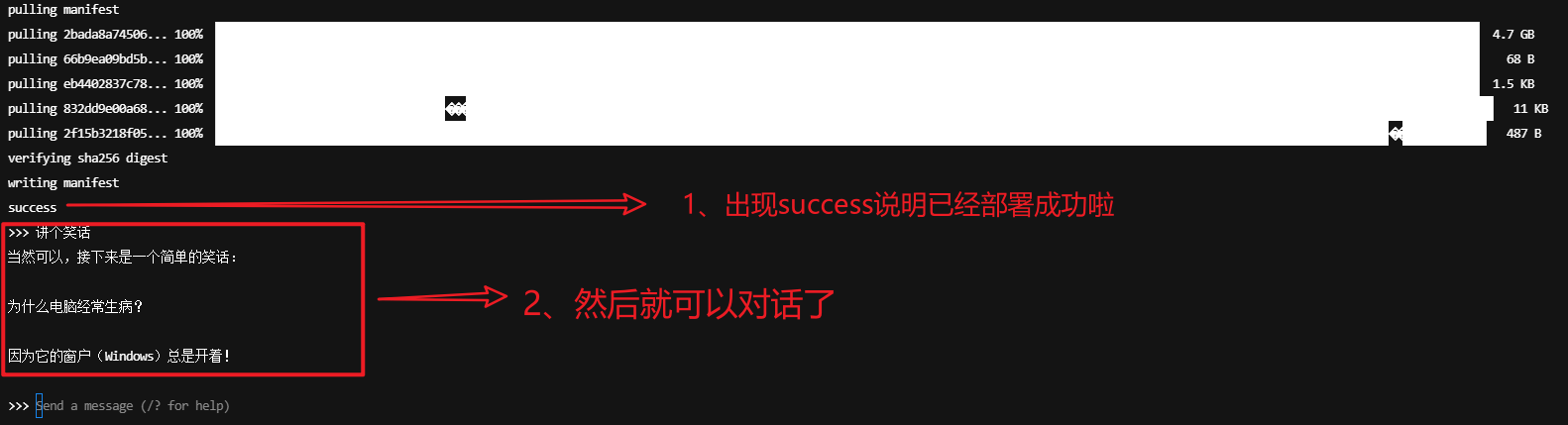

ollama run qwen2.5:0.5b #直接运行该命令,安装大模型就可以啦,qwen2.5:0.5b就是要安装的大模型

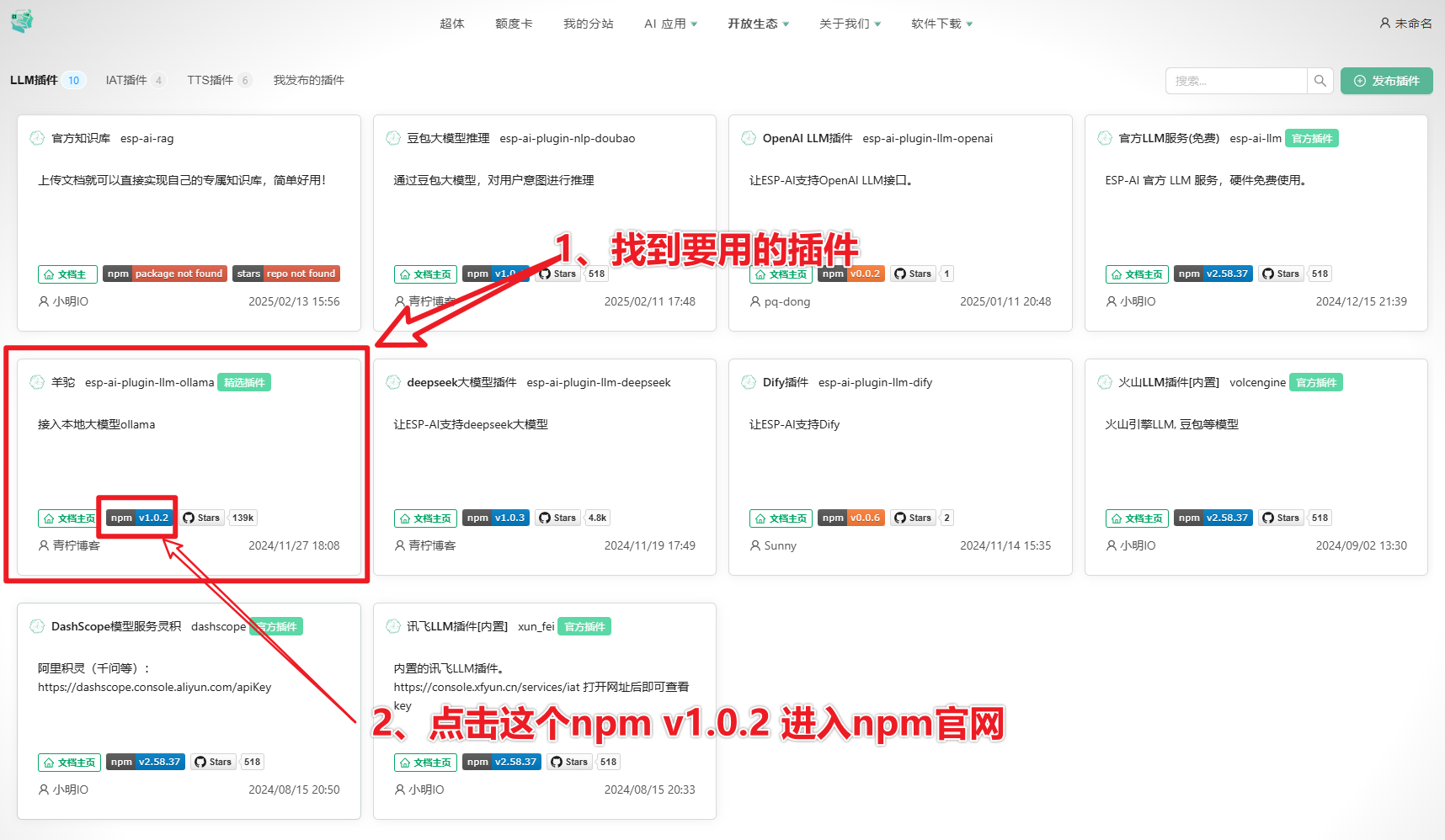

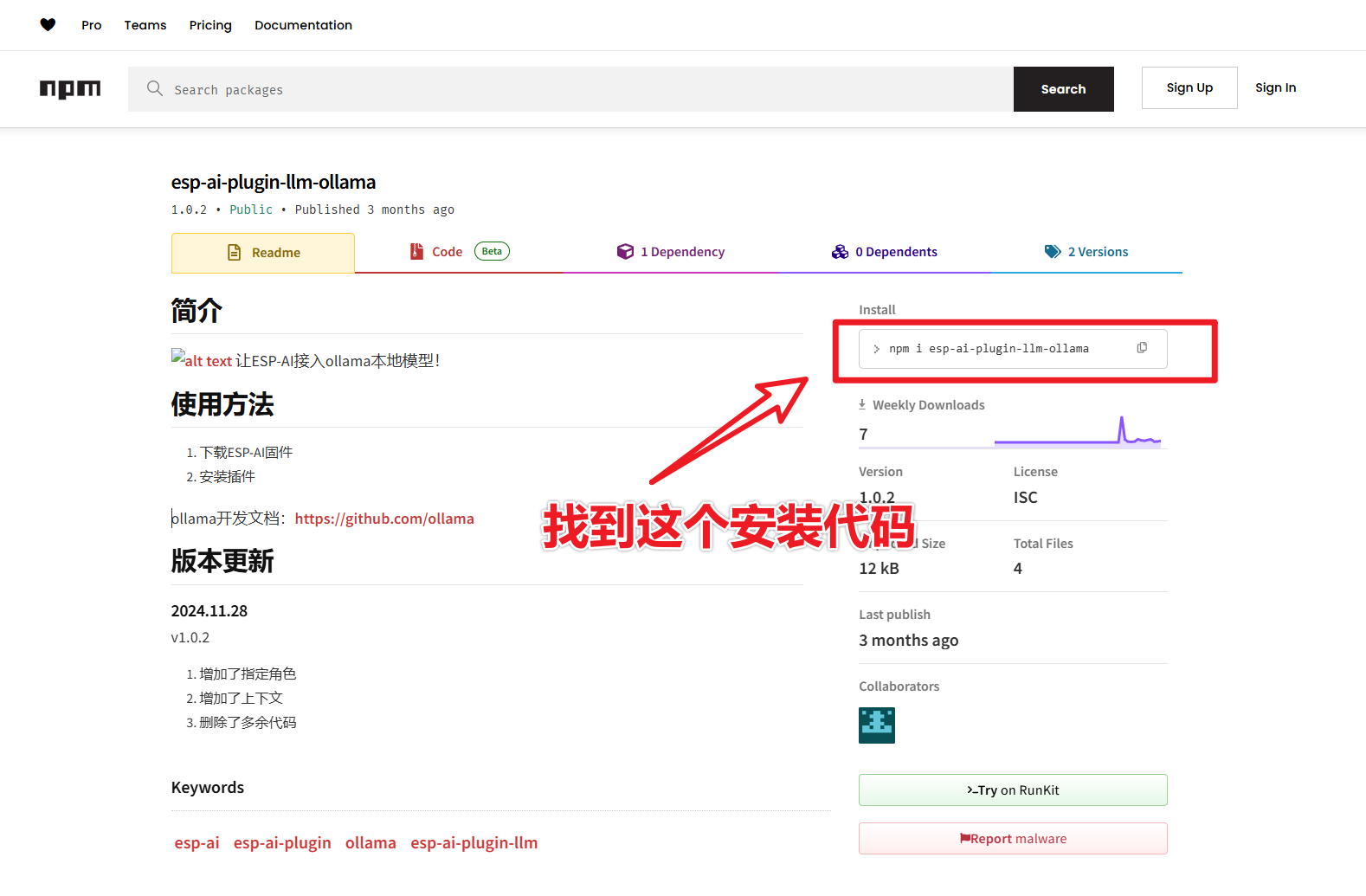

2.2 再去npm官网找到npm安装代码:

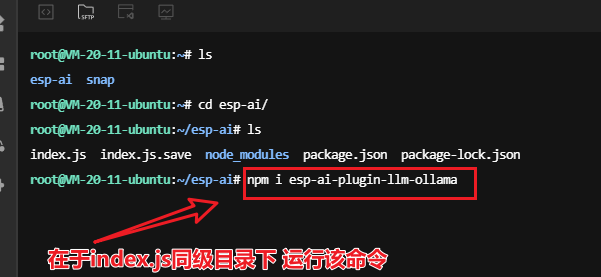

在index.js的同级目录下执行插件安装代码

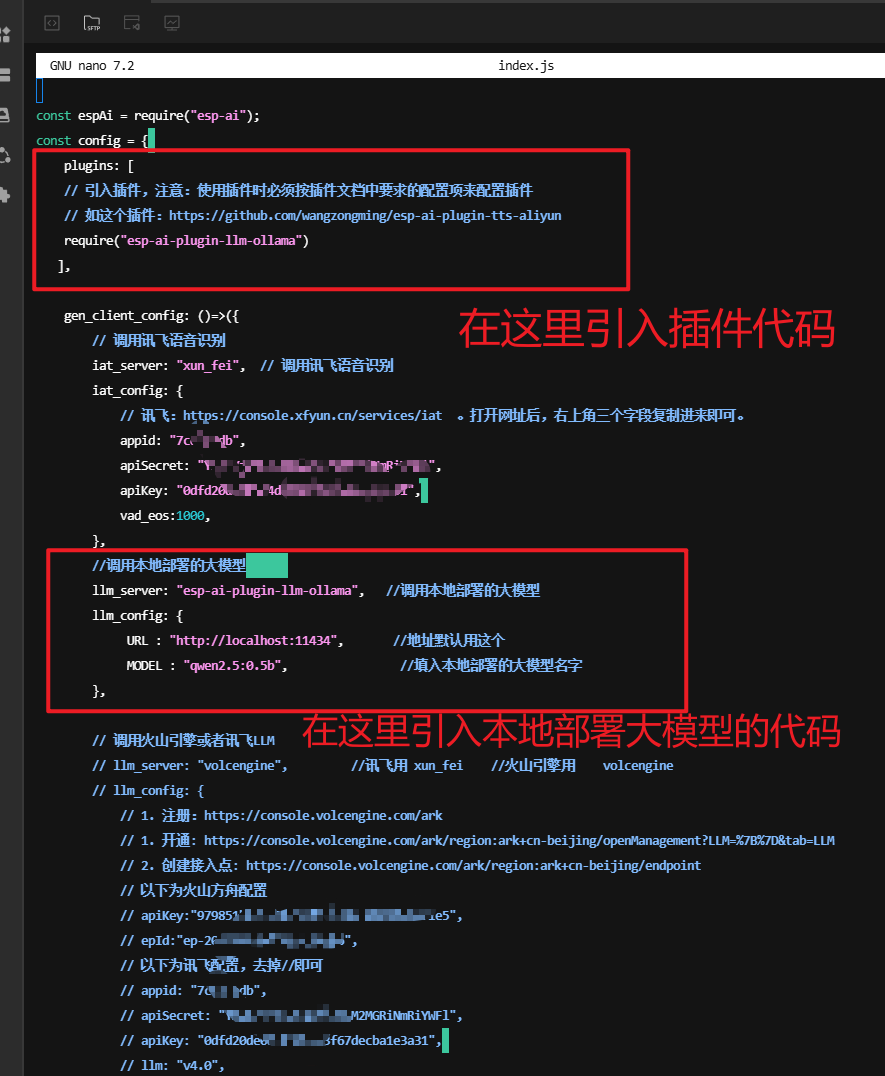

npm i esp-ai-plugin-llm-ollama2.3 然后在index.js文件中插入下面代码:

plugins: [

// 引入插件,注意:使用插件时必须按插件文档中要求的配置项来配置插件

// 如这个插件:https://github.com/wangzongming/esp-ai-plugin-tts-aliyun

require("esp-ai-plugin-llm-ollama") //这里填入的是插件的名称

],//调用本地部署的大模型

llm_server: "esp-ai-plugin-llm-ollama", //调用本地部署的大模型

llm_config: {

URL : "http://localhost:11434", //地址默认用这个

MODEL : "qwen2.5:0.5b", //填入本地部署的大模型名字

},

2.4 验证是否安装成功

© 版权声明

THE END

暂无评论内容